Algorytmy przetwarzające obraz wyspecjalizowane w rozpoznawaniu twarzy to jeden z przejawów technicznego determinizmu lub też po prostu samospełniającej się obietnicy. Dzięki literaturze czy filmowi oswoiliśmy się z myślą o nich na długo przed tym, jak naprawdę się upowszechniły. Wciąż jednak rozpoznawanie twarzy wykorzystujemy w dość błahych scenariuszach – w zautomatyzowanym oznaczaniu zdjęć na Facebooku czy podczas odblokowywania smartfonu. Gdzie podziały się dystopiczne wizje z filmów SF, w których twarz umożliwia identyfikacje obywatela w zasadzie na każdym kroku?

Algorytmy rozpoznawania twarzy – samospełniająca się dystopia

Otóż mogą być bliżej niż myślimy, przynajmniej jeśli mówimy o tzw. świecie zachodnim. Na przykład w Chinach, gdzie władza nie musi się aż tak liczyć z ewentualnym sprzeciwem alarmistów, już teraz funkcjonują z powodzeniem. Co zatem sprawia, że w Europie czy Stanach Zjednoczonych algorytmy rozpoznawania twarzy nie są jeszcze wykorzystywane w systemach monitoringu miejskiego? Na pewno nie bez znaczenia jest dostęp agencji czy samorządów do sprzętu i oprogramowania. Branża IT jest w Chinach znacznie bliższa władzom (a według niektórych – jest z władzą tożsama) niż na przykład w Europie, gdzie agencje czy samorządy muszą za sprzęt i oprogramowanie słono płacić.

Microsoft jest gotowy już teraz rozpowszechniać algorytmy rozpoznawania twarzy.

Microsoft jest gotowy już teraz rozpowszechniać algorytmy rozpoznawania twarzy. Z tym większą uwagą warto spoglądać na Zachodnie Wybrzeże Stanów Zjednoczonych, gdzie korporacje i władze już od jakiegoś czasu znajdują się w punkcie, w którym w Polsce najpewniej będziemy za kilkadziesiąt lat. Tamtejsi przedstawiciele branży IT od dawna rozprawiają nad słusznością przekazywania czy po prostu sprzedawania oprogramowania rozpoznającego twarzy władzom. Wśród kalifornijskich liberałów nie brakowało nawet propozycji, by ustanowić branżową konwencję zakazującą kupczeniem algorytmami FR. Czas negatywnie zweryfikował te próby i coraz częściej można dziś przeczytać o kolejnych planach „rozsądnego” wykorzystania rozpoznawania twarzy w bezpieczeństwie publicznym.

Spadki skuteczności w przypadku mniejszości etnicznych

Szczególnie sprawnie w tej tematyce porusza się Brad Smith, legenda działu prawnego Microsoftu, który pracuje dla korporacji od ponad ćwierć wieku. W ciągu ostatniego roku przygotował on kilka ciekawych publikacji, w których dość świeży sposób podchodzi do tematu rozpowszechnienia algorytmów rozpoznawania twarzy w życiu publicznym. Jego poglądy najlepiej podsumowuje ostatnia wypowiedź dla Business Insidera – według Smitha, zakaz sprzedawania miastom czy państwom nowych technik identyfikacji były „okrucieństwem”. Zamiast skupiać się na szpiegowaniu, inwigilacji i wyłapywaniu z tłumu podejrzanego elementu, Smith skupia się na przełomie, jaki dokonałby się w poszukiwaniach zaginionych osób. Według niego, rozpoznawanie twarzy nie musi być tylko kolejną formą opresji czy inwigilacji, lecz sposobem na ratowanie życia.

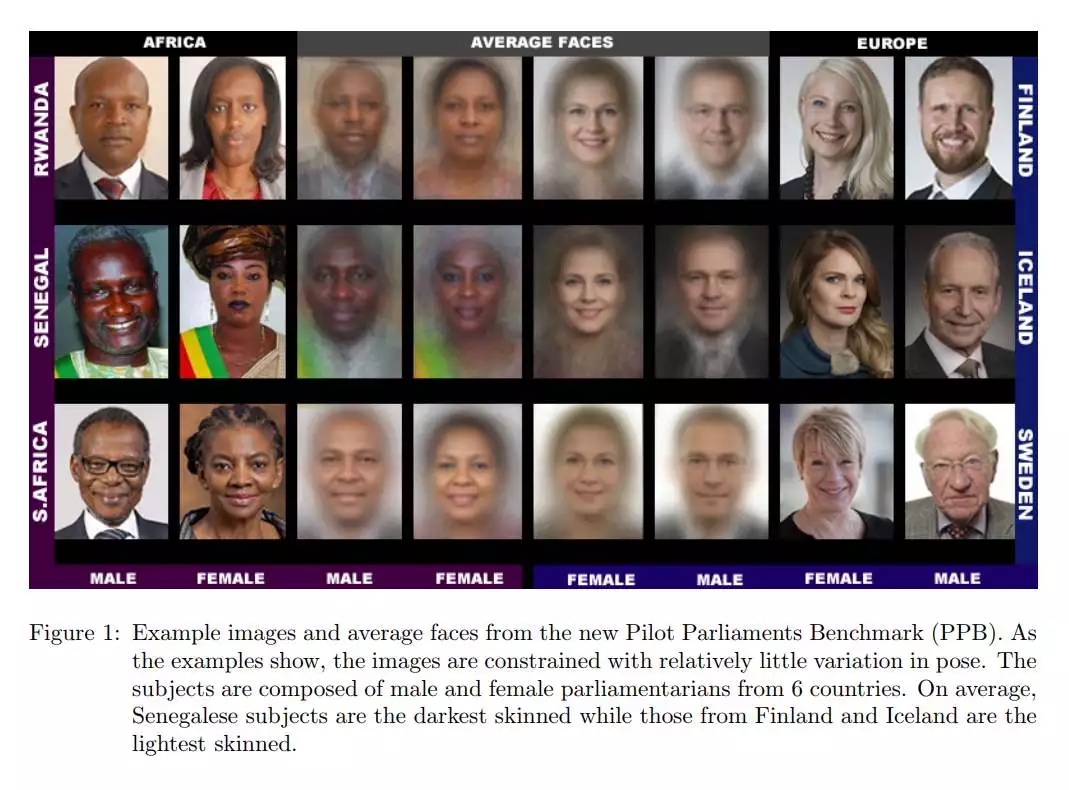

Nałożone próbki jednego z badań (baza zdjęć pilotów) – Senegalczycy byli trudniejsi do identyfikacji niż Finowie.

Nałożone próbki jednego z badań (baza zdjęć pilotów) – Senegalczycy byli trudniejsi do identyfikacji niż Finowie. Bradowi Smithowi nie sposób odmówić optymizmu. Studzą go jednak wyniki badań przeprowadzonych przez American Civil Liberties Union z wykorzystaniem Amazon Rekognition. Na podstawie 25 tys. zdjęć (był to zdjęcia z baz policyjnych oraz portrety kongresmenów) dokonano testu porównawczego – zestawiano dwie fotografie, zaś Rekognition miało określić, czy widać na nim tę samą osobę. Wyniki wzbudziły sporo kontrowersji – skuteczność algorytmów drastycznie spadała w przypadku zdjęć przedstawiających osoby rasy innej niż biała – wówczas aż w 39% przypadków Rekognition błędnie uznawało, że zdjęcia dwóch różnych osób przedstawiają tego samego człowieka. A to oczywiście wzbudziło wiele kontrowersji w szczególnie drażliwym w USA temacie – algorytmy zawodzą w rozpoznawaniu mniejszości etnicznych, co może prowadzić do nadużyć i niesłusznych skazań.

IBM – rozpoznawanie twarzy dla dobra dywersyfikacji

Jakby w odpowiedzi na ten problem, inny pomysł zaprezentował w ostatnim czasie IBM. Wiele badań wskazuje, że algorytmy rozpoznawania twarzy mają w tej chwili różną skuteczność dla różnych ras ludzi. Aby wyeliminować ten problem, IBM opracował system DiF (Diveristy in Faces), którego celem jest przetworzenie bazy złożonej z miliona fotografii. W odróżnieniu od wcześniejszych tego typu prac DiF ma przetwarzać bazę zawierającą informacje o rasach i w ten sposób wypracowywać różne wzorce. W rezultacie ma powstać nowatorski system rozpoznawania twarzy, który będzie zachowywał wysoką skuteczność bez względu na rasy, gdyż – de facto – sam będzie je od siebie odróżniał.

Warto sobie zadać prowokacyjne pytanie – czy w takim razie DiF nie będzie algorytmem… rasistowskim? Skoro różne bazy będę wykorzystywane wobec ludzi różnych etnicznie, to summa summarum cały proces będzie skuteczniejszy, ale też izolowany ze względu na rasę. A to rodzi kolejne wątpliwości, także w kontekście naszego punktu wyjścia – wyobraźmy sobie, że przekazany w ręce jakiegoś rządu system DiF trafi następne do władz, które w swojej polityce posługują się narracją rasistowską i ksenofobiczną? Wówczas będą mieli oni podane na tacy idealne, wręcz wyspecjalizowane narzędzie, do rozpoznawania „wrogów ludu”.

Chcielibyśmy podzielać entuzjazm Brada Smitha, bo na pewno ma on sporo racji, ale wszystko wskazuje na to, że rozpowszechnianie algorytmów rozpoznawania twarzy to broń obosieczna. Groźba tego, że może trafić w nieodpowiednie ręce, budzi skojarzenia z najmroczniejszymi rozdziałami historii XX wieku.