Szykuje się prawny ban na tą technologię.

Skanowanie wizerunku tylko w interesie publicznym

W nowym projektem legislacyjnym opublikowanym przez Financial Times unijni regulatorzy zaproponowali ścisłe ograniczenie stosowania rozpoznawania twarzy w przestrzeni publicznej, ograniczając użycie tej technologii do ściśle określonych wyjątków uzasadnionych interesem publicznym. W poufnym, 138-stronicowym dokumencie urzędnicy stwierdzają, że systemy rozpoznawania twarzy naruszają prawa obywatelskie jednostek i dlatego powinny być używane tylko w sytuacjach, w których jest to niezbędne, na przykład przy poszukiwaniu zaginionych dzieci lub zwalczaniu zagrożenia terrorystycznego.

W projekcie dodano też, że rozpoznawanie twarzy „w czasie rzeczywistym” - które wykorzystuje śledzenie na żywo, a nie wcześniejsze nagrania lub zdjęcia - w przestrzeni publicznej powinno być używane przez władze tylko przez ograniczony czas i powinno podlegać uprzedniej zgodzie ze strony sędziego lub organu państwa członkowskiego.

Lobbing narasta

Dokument pojawia się w sytuacji gdy obrońcy prywatności, politycy i różnego rodzaju stowarzyszenia coraz głośniej opowiadają się za uregulowaniem stosowania funkcji rozpoznawania twarzy „na żywo”. Obecnie nie ma jasnych zasad określających, w jaki sposób i gdzie ta technologia może być wykorzystywana. Omawiany projekt to pierwsza próba zapisania takich ograniczeń w prawie unijnym.

Wprowadzenie ostrzejszych ograniczeń w stosowaniu technologii rozpoznawania twarzy prawdopodobnie wznowiłoby debatę na temat tego, czy ta praktyka nie powinna czasem zostać całkowicie zakazana, ponieważ eksperci ostrzegają, że nawet przy daleko idących ograniczeniach wiąże się ona z istotnym zagrożeniem dla naszej prywatności.

Na przykład w znaczącym orzeczeniu z sierpnia ubiegłego roku brytyjski sąd apelacyjny stwierdził, że korzystanie z technologii rozpoznawania twarzy przez policję południowalijską jest niezgodne z prawem. Sąd uznał, że technologia narusza prawo do prywatności, przepisy dotyczące ochrony danych i równości wobec prawa.

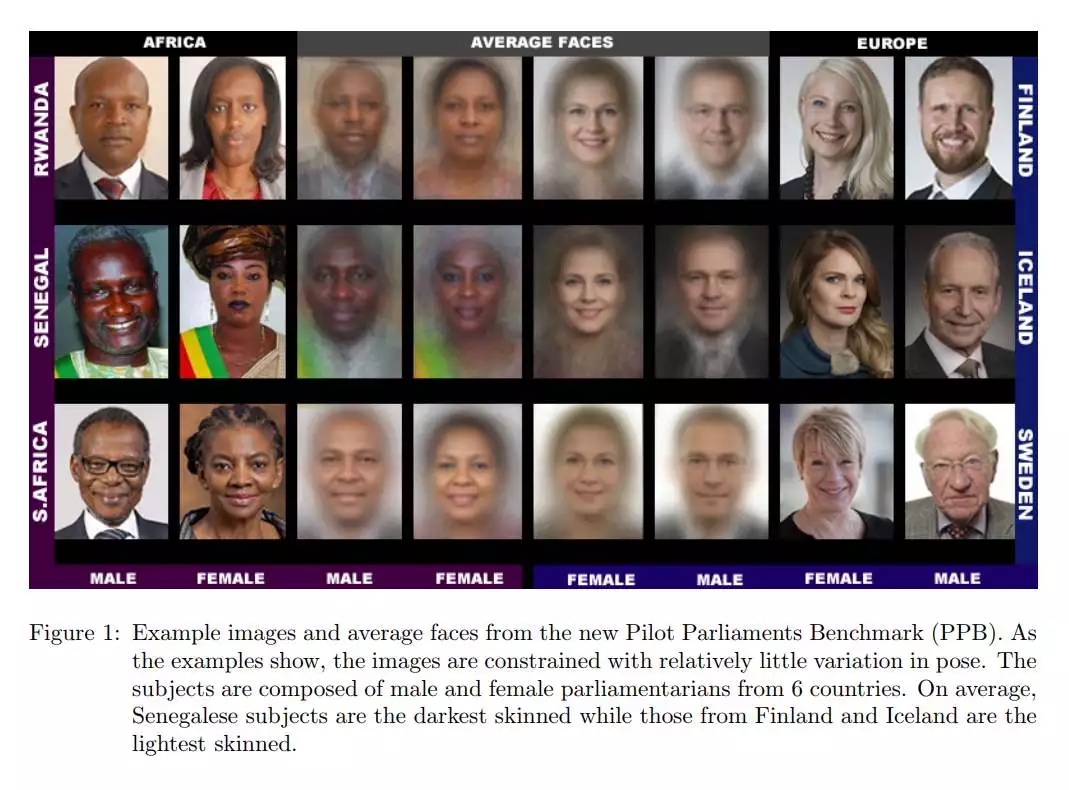

Gdy algorytmy historycznie dyskryminują…

Projekt unijny dotyczy również szeregu powiązanych kwestii, takich jak tzw. błąd algorytmiczny (a w zasadzie uprzedzenie algorytmiczne: algorythmic bias). Zdaniem twórców technologie stosowane w takich dziedzinach życia jak rekrutacja czy finanse powinny być rozwijane w ten sposób by nie powielać „historycznych wzorców dyskryminacji” grup mniejszościowych. Będzie na to bat finansowy: unijne organy regulacyjne zaproponowały grzywny w wysokości do nawet 6 procent globalnego obrotu firmy, jeśli okaże się, że nadużywa ona sztucznej inteligencji w ten sposób lub nie wykryje uprzedzeń przy zatrudnianiu pracowników lub świadczeniu usług.

Dodano też, że tak zwana ocena społeczna (social scoring), która ocenia wiarygodność osoby na podstawie zebranych na jej temat danych behawioralnych, również powinna zostać zakazane. Podany oczywisty przykład Chin, w których stosowany jest już system, który np. oblicza zdolność kredytową osoby na podstawie informacji o jej nawykach online.

Uzyskany wynik społeczny (…) może prowadzić do szkodliwego lub niekorzystnego traktowania osób lub nawet całych grup, w sytuacjach niepowiązanych z kontekstem, w którym dane zostały pierwotnie zebrane.

Omawiane propozycje będą przedmiotem debaty Parlamentu Europejskiego i państw członkowskich przynajmniej do 2023 roku, zanim staną się prawem obowiązującym w całej Unii Europejskiej.